勉強会しませんか?

AI Safety東京の勉強会は、英語と日本語とでそれぞれ個別に開催しています。

参加希望の方は、linkedin.com/in/kazuki-kimura-24b517100までご連絡ください。

本ページの下部にスクロールすると、勉強会の一覧をご覧いただけます。

AGI Strategy Course Unit4 Defence in Depth

BlueDot ImpactのAGI Strategy Courseをベースに勉強会を行なっています。

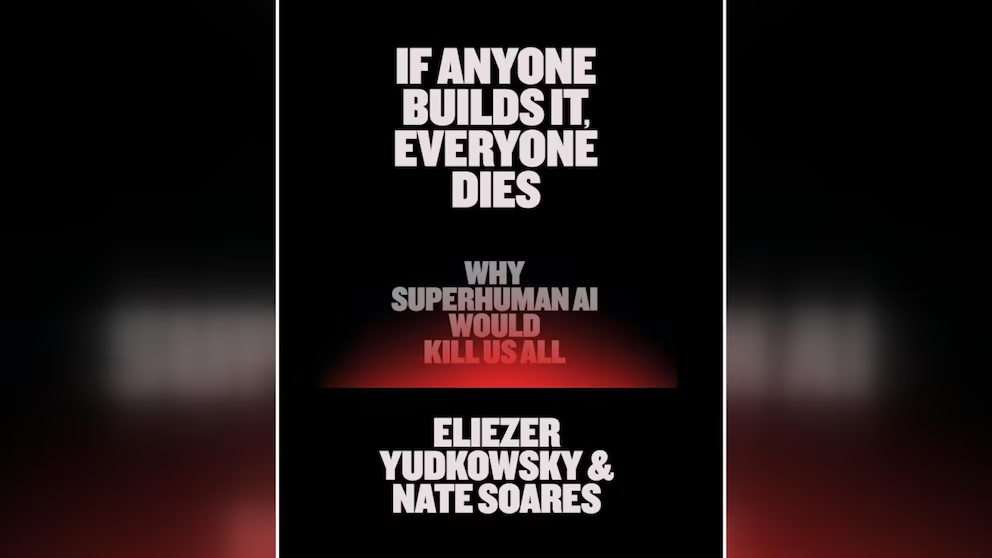

If Anyone Builds It Everyone Dies 読書会

Eliezer Yudkowskyは、AI Alignment(AIの価値観や利害を人間と一致させる技術)の分野を開拓した先駆的な研究者であり、MIRI(Machine Intelligence Research Institute)の創設者の一人です。

同研究所では、高度なAIが人類の生存にもたらす実存的リスク(Existential Risk)を回避するための数理的な基礎理論の構築に注力しています。

『IF ANYONE BUILDS IT, EVERYONE DIES』は、Eliezer Yudkowskyによる著作で、現在の延長線上でAGI(汎用人工知能)や超知能を開発することの致命的な危険性について、極めて直截的かつ論理的に説いています。

AGI Strategy Course Unit2 Drivers of AI Progress

BlueDot ImpactのAGI Strategy Courseをベースに勉強会を行なっています。

AGI Strategy Course Unit3 Pathways to Harm

BlueDot ImpactのAGI Strategy Courseをベースに勉強会を行なっています。

AGI Strategy Course Unit2 Drivers of AI Progress

BlueDot ImpactのAGI Strategy Courseをベースに勉強会を行なっています。

AGI Strategy Course Unit1 Imagining a better future

BlueDot ImpactのAGI Strategy Courseをベースに勉強会を行なっています。

AGI Strategy Course Unit1 Imagining a better future

BlueDot ImpactのAGI Strategy Courseをベースに勉強会を行なっています。

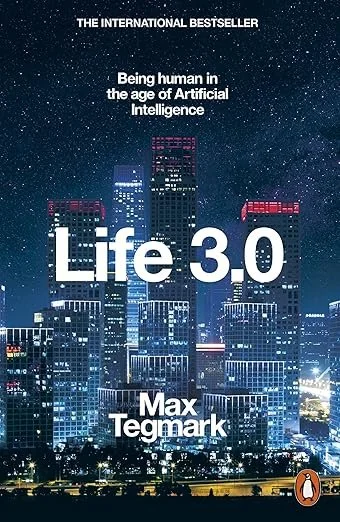

LIFE3.0 読書会(第一回)

Max TegmarkはAIや宇宙物理学を専門とする研究者で、現在はFuture of Life Instituteの所長を務めています。

同研究所では、AIという強力で、場合によっては人類の存続を脅かすほどのリスクを伴う技術を、ポジティブな方向へ導くための活動を行なっています。

『LIFE3.0』は、Max Tegmarkによる著書で、AGI(汎用人工知能)のリスクについて丁寧かつ分かりやすく説明しています。

序盤は幅広い読者層に向けたAIリスク議論への導入となっており、序章ではAGI開発によって起こりうる未来のシナリオを架空の物語として描いています。これにより、AIに馴染みのない読者でも直感的にイメージしやすくなっています。

また、「記憶とは何か」「計算とは何か」といったAIの基本原理についても、分かりやすい比喩を交えながら丁寧に解説しています。こうした工夫によって、一見難解に見えるAI研究の最前線の議論を整理し、読者を自然にその議論の核心へと導いています。

後半では、議論の中心に踏み込み、AIがもたらすリスクについて具体的に論じています。雇用・兵器への悪用・セキュリティといった社会的課題にも触れながら、「AIにとって何が問題なのか」を多面的に掘り下げています。